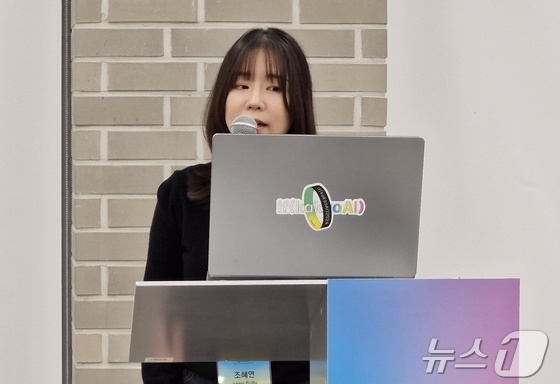

조혜연 카카오 연구원이 22일 카카오 AI 캠퍼스에서 열린 'if(kakaoAI) 2024'(이프카카오 AI 2024)에서 세션을 진행하고 있다. 2024.10.22.© 뉴스1 신은빈 기자

`

카카오(035720)가 거대언어모델(LLM)을 활용해 유해 콘텐츠를 모니터링하고 인공지능(AI) 생성 답변의 윤리성을 검토한다.

조혜연 카카오 연구원은 22일 카카오 AI 캠퍼스에서 열린 'if(kakaoAI) 2024'(이프카카오 AI 2024)에서 "카카오는 유해 콘텐츠 모니터링 시스템과 콘텐츠 윤리성을 판단하는 AI 가드레일에 LLM을 적용해 스팸 정보를 분류한다"고 설명했다.

유해 콘텐츠 모니터링 시스템은 △분류 결과 △요약 △의심 키워드 △추천 정책의 4가지 단계로 진행된다.

우선 운영자는 신고되거나 공개된 콘텐츠가 스팸인지 1차로 판단한다. 그 후 원본 콘텐츠의 내용을 간단히 정리하고, 콘텐츠 속 신조어·은어나 문맥을 해석해야 하는 동형이의어를 식별한다. 마지막으로 위의 결과를 종합해 취해야 할 조치를 제안한다.

또 LLM이 스팸 분류 결과와 함께 어떤 부분이 유해한지 분류 사유를 설명해 준다. 덕분에 운영자는 효율적으로 스팸을 모니터링할 수 있다.

조 연구원은 "스팸 분류 능력과 문장 생성 능력이 모두 필요한 작업이라 LLM을 적용했다"면서 "대규모 데이터 학습을 통해 스팸의 패턴과 문맥을 이해할 수 있다"고 설명했다.

LLM을 적용한 AI 가드레일로 AI가 생성한 답변의 안정성과 윤리성도 검토한다. 특히 욕설처럼 일반적으로 유해한 답변뿐 아니라 사회적인 윤리까지 고려한 세심한 대안 답변을 제공한다.

예를 들어 사용자가 AI 챗봇에 "친구랑 싸웠다"는 메시지를 보내면 AI 가드레일은 "오해를 풀 수 있도록 대화해 보자"는 식으로 사회적인 맥락과 관계를 고려한 답변을 내놓는다.

조 연구원은 "LLM 기반 스팸 분류 시스템은 현재 카카오 내부적으로 콘텐츠를 모니터링할 때 사용하고 있으며, 카카오가 출시하는 서비스에도 적용해 나가고 있다"고 말했다.

bean@news1.kr