30일 오후 서울 강남구 코엑스 오디토리움에서 열린 ‘독자 AI파운데이션 프로젝트’ 발표회에서 참관객들이 SK텔레콤의 AI모델 ‘A.X K1’을 체험하기 위해 줄을 서고 있다.(사진=뉴스1)

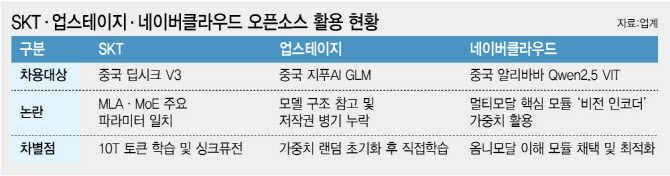

배주호 한국외대 Language & AI 융합학부 교수는 이데일리와의 통화에서 “5개 컨소시엄 모두 오픈소스를 일부 사용했을 가능성이 크고, 상업적 개발에서는 흔한 일”이라면서도 “논란이 커지는 이유는 사용 사실 자체가 아니라 투명성과 라이선스, 설명 부족 때문”이라고 말했다.

최병호 고려대 AI연구소 교수는 현행 과기정통부 가이드라인의 구조적 한계를 짚었다. 그는 “가이드라인이 ‘방향성’ 수준에 머물러 강제 조항으로 기능하지 못한다”며 “해석에 따라 되는 것도, 안 되는 것도 없는 모호함이 지금의 혼선을 키웠다”고 진단했다. 국가 예산이 투입되는 사업인 만큼, 무엇을 왜 어떻게 썼는지에 대한 설득 가능한 논리, 즉 ‘기술적 정직함’을 요구하는 명확한 기준이 필요하다는 주장이다. 배경훈 부총리 겸 과학기술정보통신부 장관도 “평가는 객관적이고 공정해야 하며, 윤리적으로도 공감 가능한 수준이어야 한다”고 강조한 바 있다.

[이데일리 김정훈 기자]

최 교수는 “산업 전반에서 이 기술을 활용하는 과정에서 라이선스 문제가 터지면 국내 생태계가 이를 감당하기 어렵다”며 “처음부터 기술 노하우가 전수되고 내재화되도록 설계해야 한다”고 말했다. 배 교수 역시 “코드와 구조를 장악하지 못하면 보안 사고나 백도어 위험 같은 안보 이슈에 대응할 수 없다”며 “수정 가능한 역량이 없다면 사실상 통제력이 없는 것”이라고 지적했다.

평가 지표 자체를 손질해야 한다는 목소리도 나온다. 사업 초기 제시된 ‘글로벌 상용 모델 대비 성능 90%’ 목표가 지나치게 포괄적이어서, 기술 내재화와 통제력 확보를 평가로 유도하기 어렵다는 이유다.

아울러 이번 5개 모델의 성격이 서로 달라 단일한 벤치마크 테스트를 적용하기 쉽지 않다는 점도 과제로 꼽힌다. 네이버클라우드는 AI가 다루는 정보를 글뿐 아니라 이미지나 음성 같은 다른 형태로 확장한 반면, 나머지 4개 팀은 글 중심 모델이어서 동일 기준으로 비교하기 어렵다는 평가다. 다만 중장기적으로는 벤치마크 기반 평가가 불가피하다는 데에는 대체로 의견이 모인다. 배 교수는 “독파모 평가는 데이터셋 설계를 핵심으로 삼아 벤치마크 중심의 공개 평가로 가야 한다”며 “허깅페이스 등 공개 플랫폼에 올려 외부 검증을 받는 방식이 필요하다”고 말했다. 이어 “검증 과정 자체를 정부의 관리 체계와 인재 육성의 자산으로 삼아야 한다”고 덧붙였다.