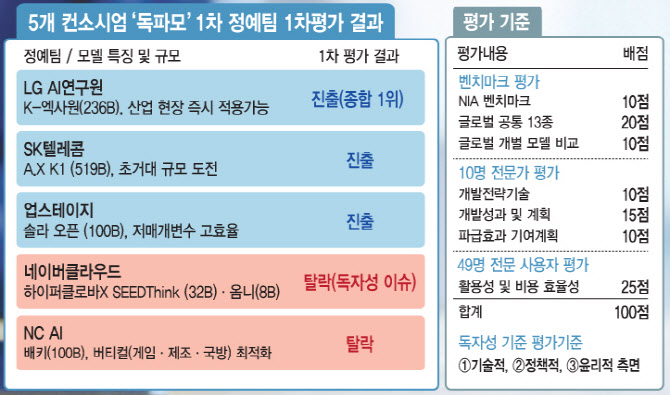

네이버클라우드가 제출한 ‘하이퍼클로바X SEED 8B Omni(옴니모달)’에서 중국 알리바바의 Qwen2.5-ViT ‘비전 인코더’ 가중치를 그대로 사용한 사실이 확인됐기 때문입니다.

류제명 과학기술정보통신부 제2차관은 “독자 AI는 자체 데이터로 가중치를 학습·검증한 경험이 핵심”이라며 “가중치를 그대로 사용한 점이 네이버 기술보고서에도 언급돼 있지만, 독자 모델 요건을 충족하지 못한 것으로 판단했다”고 설명했습니다.

기사와 무관함.(사진=게티이미지)

이번 탈락이 던진 메시지도 적지 않습니다. ①평가기준의 구체화 필요성 ②경쟁 과열에 따른 비방전 ③국가대표 AI(독자 AI 파운데이션 모델) 프로젝트가 지향해야 할 방향을 되돌아보게 했습니다.

정부는 이번 평가에서 “오픈소스를 쓰더라도 가중치를 초기화해 처음부터 학습해야 한다”는 큰 원칙을 세웠지만, 이 기준만으로는 충분하지 않습니다. 기준이 더 선명했다면, 기업들이 제출 전략을 ‘출제 의도’에 맞추는 과정에서 생길 혼선도 줄일 수 있었을 것입니다.

이번에 2차에 오른 LG AI연구원·SK텔레콤·업스테이지 컨소시엄 역시 오픈소스를 활용한 만큼, 라이선스·권리 관계를 명확히 정리하는 과제가 남아 있습니다. 국가 예산이 투입된 ‘국가대표 AI’라면, 유사시(안보·재난 등) 핵심 시스템에 적용되더라도 외부 제약 없이 국내에서 통제·운영할 수 있어야 한다는 문제의식이 따라붙기 때문입니다.

평가 방식도 손질이 필요합니다. 이번 심사 대상 5개 컨소시엄 가운데 네이버만 텍스트 모델과 옴니모달 모델을 동시에 제출해, 일률적인 벤치마크로 비교하기 어려운 측면이 있었습니다. 네이버는 텍스트뿐 아니라 이미지·음성까지 다루는 방향으로 확장했지만, 나머지 팀은 텍스트 중심 모델이어서 같은 잣대로 평가하기가 애초에 까다로웠던 셈입니다.

다만 이번 탈락의 직접 사유는 ‘독자성 요건 미충족’으로 정리됩니다. 그럼에도 옴니모달·텍스트 모델이 혼재하는 상황에서 어떤 벤치마크와 평가 프레임이 합리적인지, 정부가 더 구체적 설계를 제시할 필요가 있습니다. 네이버 입장에선 기술적으로 앞서가려다 평가 프레임을 정확히 맞추지 못한 ‘정무적 판단 미스’로 비칠 여지도 있습니다.

[이데일리 김일환 기자]

‘국가대표 AI 선발전’은 2027년까지 약 2000억원의 국가 예산을 투입해 GPU와 학습데이터 등을 지원하는 AI 모델 개발 프로젝트입니다. GPU 부족으로 개발이 막히거나, “차라리 해외 모델을 쓰자”는 현업 압박에 시달려온 국내 AI 기업들에겐 가뭄의 단비 같은 사업이었습니다.

이번에 탈락한 NC AI만 보더라도 ETRI, KAIST, 고려대, 서울대, 연세대 등 산학연 14곳과 수요기업 40곳을 포함해 총 54개 기관이 컨소시엄에 참여했습니다. 정부가 ‘국가대표 AI’를 뽑겠다고 하자 국내 주요 기업·연구소·대학이 한데 모여 AI 개발에 집중할 여건이 만들어진 셈입니다. 탈락 여부와 별개로 투자와 인재, 협업 네트워크라는 성과를 남겼다는 평가가 나오는 이유입니다.

문제는 경쟁이 과열되면서 물밑 비방전도 커졌다는 점입니다. 단일 벤치마크로 성격과 규모가 다른 팀들을 일률 비교하는 한계가 있는데도, 이를 보완하기 위한 ‘복수 평가’ 논의마저 ‘특혜’ 프레임으로 몰아붙이는 움직임이 있었습니다.

앞으로는 이런 비방전이 프로젝트의 신뢰를 갉아먹지 않도록 정부가 명확한 원칙을 세우고 엄중히 경고할 필요가 있습니다.

③ 독자 AI 파운데이션 모델은 무엇을 지향해야 하는가

네이버는 정부가 예고한 상반기 중 ‘패자부활전’에 재도전하지 않겠다고 밝혔고, “1단계 평가에 대한 과기정통부 판단을 존중한다”는 입장도 내놨습니다.

담담한 결정이지만, 한편으론 아쉬움도 남습니다. 출제 의도와 평가 프레임을 정확히 맞추지 못해 탈락한 만큼, 다시 도전하면 성과를 낼 여지가 있었기 때문입니다. 반대로 재도전에 성공하더라도 일부에서 ‘네이버 특혜’ 프레임을 씌울 가능성이 큰 만큼, 이번 불참이 결과적으로 정부 부담을 덜어준 측면도 있어 보입니다.

다만 네이버의 탈락이 기술력 부족을 의미한다고 단정하긴 어렵습니다. 네이버는 오픈AI(GPT-3, 2020년 6월), 화웨이(Pan-GU, 2021년 5월)에 이어 2021년 11월 세계에서 세 번째로 초거대 AI ‘하이퍼클로바 LLM’을 개발한 기업으로 꼽힙니다. 최근에는 글로벌 오픈 가중치 모델 성능 지표(AAII)에서 LG AI연구원(K-엑사원) 7위에 이어 11위(하이퍼클로바X SEED Think 32B)를 기록한 바 있습니다. 당시 1~15위 분포는 중국 8개, 미국 4개, 한국 2개, 프랑스 1개였습니다.

여기에 최근 엔비디아 B200 4000장 기반 클러스터 구축도 완료한 만큼, 자체 개발에 일정 물량만 투입해도 경쟁력 있는 모델을 충분히 만들 수 있다는 평가가 나옵니다.

그래서 질문이 남습니다. ‘독자 AI 파운데이션 모델’ 프로젝트는 무엇을 지향해야 할까요. 모델 자체의 성능 경쟁도 중요하지만, 결국 AI는 클라우드에서 서비스되고, 좋은 모델은 API 형태로 산업과 생태계에 확산될 때 경쟁력이 커집니다.

그렇다면 이번 기회를 계기로, 모델·데이터·플랫폼·클라우드를 모두 보유한 네이버가 ‘직접 참여’가 아니라 공개 API, 안전·거버넌스 기준, 벤치마크 운영 등 ‘공개 자산’ 형태로 생태계에 기여하는 방식도 고민해볼 만합니다.

‘국가대표’라는 이름이 단일 승자만 남기는 구조가 아니라, 산업 전체의 역량을 끌어올리는 구조로 설계돼야 하기 때문입니다.

정부가 상반기 중 탈락팀은 물론 초기 공모 참여 기업(모티프, KT, 카카오 등)까지 문호를 열어 1개 팀을 추가 선발하겠다고 한 만큼, 다음 단계에서는 평가 기준의 명확화와 함께 ‘생태계 확산’이라는 목표가 더 뚜렷해지길 기대합니다.