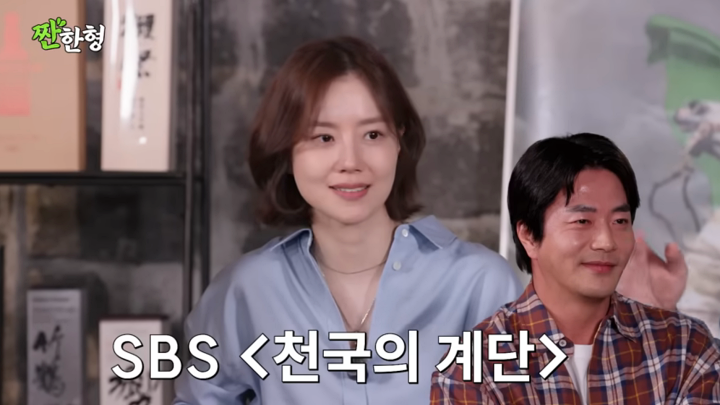

임정환 모티프테크놀로지 대표(사진=모티브)

모티프테크놀로지스는 “고성능의 LLM(대형언어모델)과 LMM(대형멀티모달모델) 모두를 파운데이션 모델로 개발한 경험을 갖춘 국내 유일의 스타트업으로서, 한국의 기술 독자성을 증명하기 위해 노력할 예정”이라고 강조했다.

모티프테크놀로지스가 지난해 11월 공개한 대규모 언어 모델(LLM) ‘Motif 12.7B’는 모델 구축부터 데이터 학습까지 전 과정을 직접 수행한 순수 국산 기술의 집약체다.

특히 기존 트랜스포머 구조를 그대로 쓰지 않고, ‘그룹별 차등 어텐션(GDA)’ 기술을 자체적으로 개발해 적용했다. 이는 단순히 모델을 바닥부터 학습시키는 ‘프롬 스크래치(From Scratch)’를 넘어 지능의 핵심인 어텐션 함수와 모델의 아키텍처 자체를 새롭게 설계한 것으로 독자성을 높게 평가받고 있다.

실제 이 모델은 글로벌 AI모델 성능을 종합평가하는 ‘아티피셜 애널리시스’의 인텔리전스지수(AAII)에서 12.7B 파라미터의 비교적 작은 LLM임에도 675B에 달하는 미스트랄 라지(Mistral Large) 3와 같은 대형 LLM보다도 높은 점수를 기록하며, 작은 규모로 고효율을 내는 ‘설계의 힘’을 입증했다.

작년 7월 독파모 프로젝트 정예팀 공모에 접수한 15개 컨소시엄 주관기업 가운데, 2차 단계에서는 LG AI연구원과 업스테이지, SK텔레콤 등 3개 컨소시엄이 경쟁 구도를 형성한 상태다. 정부는 이들과 함께 경합할 추가 1개 컨소시엄을 ‘재도전’ 방식으로 선발할 계획이다.

류제명 과기정통부 2차관은 지난 15일 브리핑에서 “추가 참여 기업에도 총 프로젝트 기간과 정부가 지원하는 GPU·데이터는 동일하게 설계해 제공할 것”이라며 “프로젝트 종료 시점이 다르더라도 2단계를 마칠 때까지 동일한 기간을 보장하고, 평가는 6~7월로 한 달 정도 유연하게 운영할 계획”이라고 밝혔다.